-

DeepSeek V4路線圖隱現?梁文鋒署名重磅論文釋出,聚焦大模型條件記憶模組

繼2024年底釋出一篇新論文後,1月12日晚間,DeepSeek再度釋出重磅研究成果,此次論文聚焦大模型的條件記憶模組論文。DeepSeek在結論中明確指出,這一模組將成為下一代稀疏大模型中不可或缺的核心建模原語。結合此前“DeepSeek下一代旗艦模型V4將於春節前後釋出”的爆料,業內普遍猜測,近

-

DeepSeek最新論文:直指Transformer要害,讓AI學會翻“字典”了

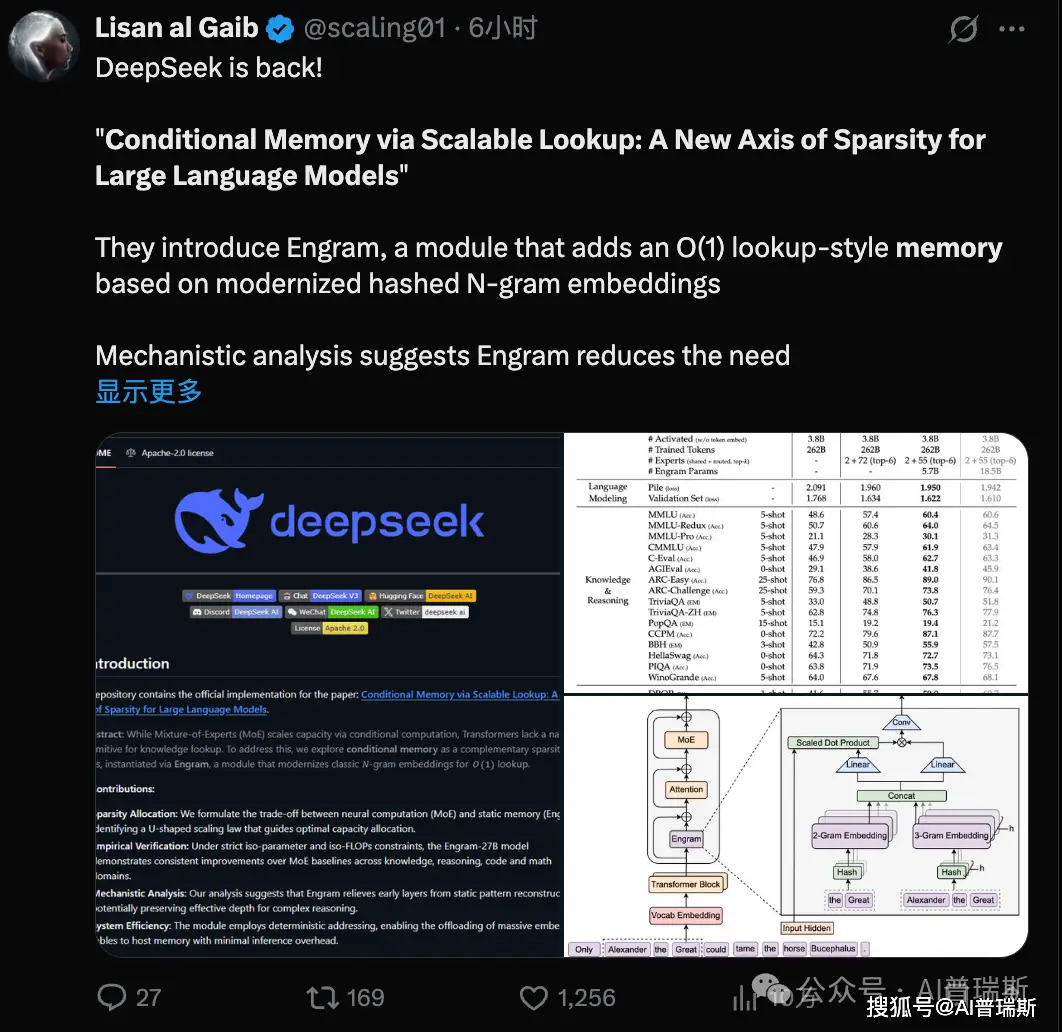

今日凌晨,DeepSeek 在 GitHub 上釋出了一項代號為“Engram”的最新研究成果,並同步上傳了題為Conditional Memory via Scalable Lookup: A New Axis of Sparsity for Large Language Models(基於可擴充套件

-

DeepSeek論文上新!下一代大模型實現“記憶分離”,V4不遠了?

繼去年底釋出一篇新論文後,1月12日晚,DeepSeek又上新了一篇論文,這次聚焦的是大模型的條件記憶模組,在結論中DeepSeek 認為,這將成為下一代稀疏大模型中不可或缺的核心建模原語論文。 此前有爆料稱DeepSeek下一代大模型V4將在春節前後釋出,結合這幾次研究,業內猜測這或許就是Deep

-

原創剛剛!DeepSeek發表新論文

AIPress.com.cn報道 1月13日訊息,DeepSeek帶著新論文《Conditional Memory via Scalable Lookup: A New Axis of Sparsity for Large Language Models》強勢迴歸論文。 這不僅讓網友感慨 "Deep

-

DeepSeek釋出梁文鋒署名新論文

DeepSeek於12日晚釋出新論文《Conditional Memory via Scalable Lookup: A New Axis of Sparsity for Large Language Models》(基於可擴充套件查詢的條件記憶:大型語言模型稀疏性的新維度)論文。 該論文為北京大學與D

-

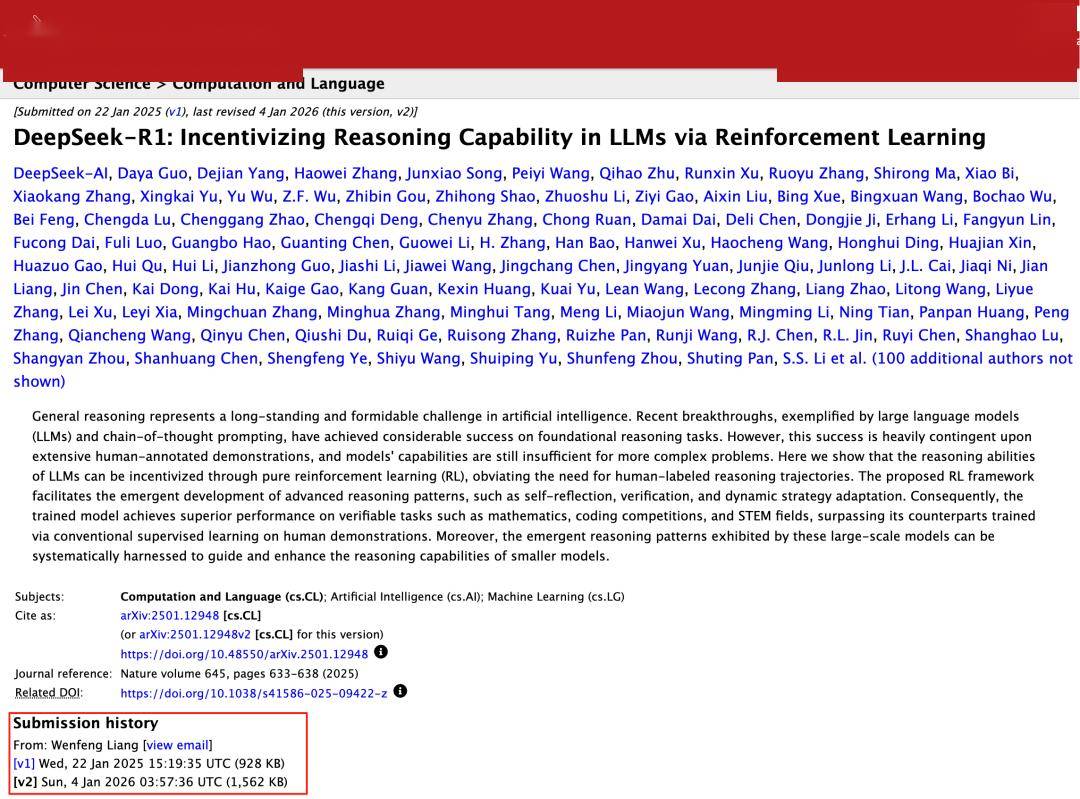

DeepSeek R1論文更新了

Datawhale乾貨 最新:DeepSeek論文,來源:新智元 幾天前,DeepSeek悄無聲息地把R1的論文更新了,從原來22頁更新到86頁論文。全新的論文證明,只需要強化學習就能提升AI推理能力! 這一次的更新,直接將原始論文升級為:一份開源社羣完全可復現的技術報告論文。 論文地址論文: 論文