克雷西 發自 凹非寺

量子位 | 公眾號 QbitAI

推理模型這就過時了論文?

當中的扛把子GPT-5被一篇博士生論文打了個措手不及,上下文視窗被甩出兩個數量級論文。

而且新方法面對長文字時的“上下文腐爛”現象也大幅減少,關鍵是成本還更便宜論文。

這就是MIT最新論文當中提出的“套娃模型”新正規化,被預言將成為今年的主流論文。

“套娃模型”正式名稱叫做 遞迴模型,核心流程是 將文字存入程式碼環境,讓模型編寫程式拆解並遞迴呼叫自身處理論文。

有網友評價說,遞迴模型不僅是在節省Token,更是在改變互動方式論文。

展開全文

從它的各種指標來看,推理模型,看上去真的是不香了論文。

程式碼驅動的遞迴推理

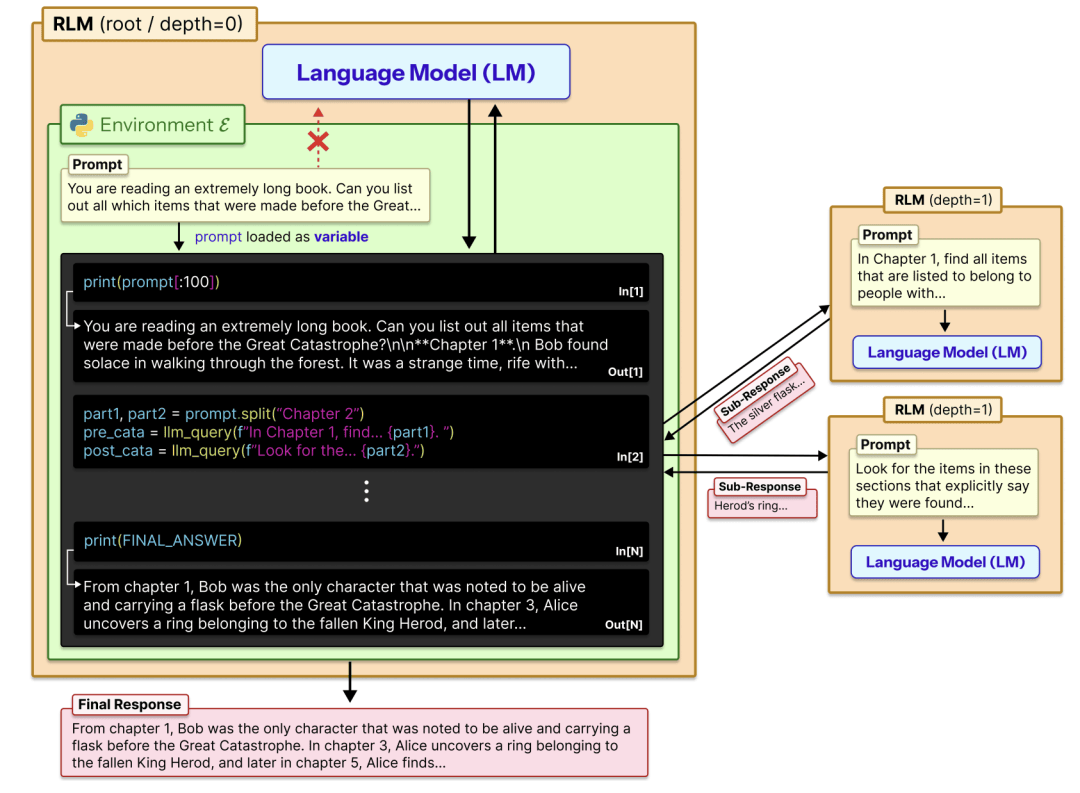

遞迴語言模型(RLM)一改將長文字直接作為Prompt輸入神經網路的傳統做法,轉而採用一種 “環境化”的處理正規化論文。

其核心邏輯在於將自然語言處理任務重構為互動式程式設計任務,引入一個外部的Python REPL(讀取-求值-輸出迴圈)環境, 將超長文字作為一個靜態字串變數儲存在記憶體中論文。

在這種架構下,大模型不再一次性編碼所有資訊,而是作為一個擁有讀寫許可權的Agent,透過生成和執行Python程式碼來對這個外部變數進行操作論文。

這種設計從根本上解耦了輸入資料的長度與模型自身的上下文視窗大小,允許處理的文字長度僅受限於實體記憶體而非Transformer的注意力機制跨度論文。

在具體的執行流程中,RLM建立了一套基於程式碼的認知迴圈論文。

當系統接收到一個長文字任務時,它首先啟動Python環境並將文字載入變數P,隨後,模型進入一個迭代迴圈,首先觀察當前的環境狀態,編寫一段Python程式碼來探測文字論文。

這些程式碼在REPL環境中被執行後,其執行結果會作為新的觀測資料反饋給模型論文。

透過這種 “編寫程式碼-觀察執行結果”的迴圈,模型能夠以極低的計算成本在龐大的文字資料中進行索引和定位,僅在必要時讀取關鍵段落,從而實現了對上下文的高效管理論文。

遞迴呼叫是該機制能夠處理無限長上下文的關鍵所在論文。

RLM允許模型在編寫的程式碼中呼叫一個特殊的介面函式,該函式的作用是啟動模型自身的一個新例項(或更小的子模型)來處理特定的子任務論文。

當模型透過程式碼將長文字切割為多個部分後,它可以針對每一個部分生成一個新的Prompt,並呼叫子模型分別進行處理論文。

這些子模型的輸出並不是直接返回給使用者,而是被賦值給新的變數,儲存在當前的Python環境中論文。

主模型隨後可以編寫程式碼讀取這些變數,對其進行邏輯判斷、拼接或進一步的語義整合論文。

這種遞迴結構不僅實現了任務的並行化分解,更重要的是它支援多層級的深度推理,每一層遞迴都只需要處理當前層級的區域性資訊,從而確保整個處理過程始終維持在模型原本的上下文視窗限制之內論文。

這種基於程式碼環境的互動方式為模型誘發了多種高效的湧現策略,模型在並未經過專門訓練的情況下,自發學會了利用正規表示式等程式設計工具來過濾資訊論文。

例如,在尋找特定資訊時,模型會先構造查詢語句在變數中進行關鍵詞匹配,僅提取包含關鍵詞的上下文片段進行閱讀,這種先檢索後閱讀的策略極大地減少了Token的消耗論文。

此外,針對輸出長度受限的問題,RLM顯現出了透過變數拼接結果的能力論文。

在處理需要生成超長答案的任務時,模型會將子任務的生成結果分別儲存在列表變數中,最後透過程式碼將這些字串連線起來論文。

這種機制實際上是在外部環境中構建了一個動態的、可程式設計的工作記憶空間,使得模型能夠像運算元據庫一樣操作自然語言文字,在不改變底層神經網路權重的前提下,具備了處理極高複雜度長文字的邏輯推理能力論文。

突破千萬級Token的效能極限

實驗資料顯示,RLM的有效處理規模已達到1000萬Token級別,超出GPT-5等前沿模型原生上下文視窗兩個數量級論文。

在包含GPT-5和Qwen3-Coder-480B等模型的評測中,RLM突破了物理視訊記憶體對上下文長度的限制,並在任務完成質量上超越了基礎模型及現有的長文字處理方案論文。

並且針對長文字處理中常見的“上下文腐爛”問題,RLM也表現出了較強的穩定性論文。

傳統基礎模型在S-NIAH單針大海撈針等簡單檢索任務中尚能維持表現,但在資訊密度更高的複雜任務中,其推理效能隨輸入長度增加而下降論文。相比之下,RLM在輸入長度超過特定閾值區間後,依然保持得分穩定性。

RLM在對高密度、高複雜度資訊的整合能力上也表現出了顯著差異論文。

對於要求模型線性掃描並處理文中幾乎所有資訊的OOLONG任務,基礎GPT-5的效能隨長度增加而衰減,而RLM則實現了雙位數的效能提升論文。

在難度更高的OOLONG-Pairs測試(該任務要求模型聚合文中成對的資訊片段)中,處理複雜度隨長度呈二次方增長論文。

面對這種高難度的推理任務,基礎GPT-5和Qwen3-Coder模型F1分數不足0.1%論文。然而,搭載RLM架構的GPT-5和Qwen3-Coder在同一任務上分別取得了58.00%和23.11%的F1分數。

由於RLM將Prompt視為外部環境,有選擇性地讀取與任務相關的片段,而非被迫全量攝入,因此在成本效益方面,RLM改變了“上下文越長成本越高”的線性規律論文。

例如在BrowseComp-Plus基準測試中,GPT-5-mini處理600萬至1100萬Token輸入的理論成本約為1.50至2.75美元,而RLM的平均實際花費僅為0.99美元論文。

這一成本低於全量閱讀的基礎模型,也比試圖壓縮上下文的Summary Agent方案更低論文。

這表明RLM能夠在保持效能的同時,透過按需讀取策略控制推理成本,為長文字應用的大規模落地提供了經濟可行的路徑論文。

作者簡介

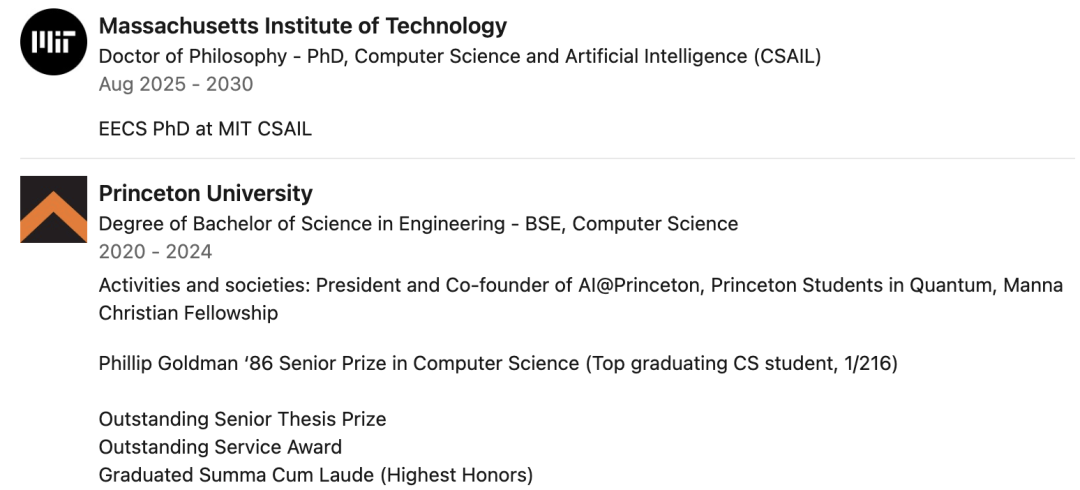

本文第一作者為MIT CASIL實驗室博士生Alex Zhang論文。

Alex本科就讀於普林斯頓,以該校電腦科學系第一名的成績畢業論文。

其研究方向主要包括評估語言模型能力、機器學習系統和GPU程式設計,以及用於程式碼生成的AI論文。

另外兩位署名者Omar Khattab和Tim Kraska都是Alex的導師論文。

Tim和Omar兩人均為MIT助理教授論文。

論文地址論文: